For at hjælpe din virksomhed med at udnytte generativ AI's store potentiale, samtidig med at I effektivt håndterer risici og overholder lovgivningsmæssige krav – har vi i PwC udviklet frameworket 'Responsible AI'.

PwC's Responsible AI består af et sæt velafprøvede metoder og værktøjer designet til at fremme etisk og ansvarlig brug af AI, hvilket er blevet endnu mere afgørende med den hastige udvikling inden for generativ AI og den nye AI-forordning (EU’s AI Act).

Mulighederne og begrænsningerne ved generativ AI

Ved at bruge enkle sprogkommandoer (prompts) kan du instruere generativ AI til at generere softwarekode, dataanalyser, tekst, videoer, menneskelignende stemmer, rapporter og meget mere. Over tid forventes disse funktioner at transformere jobfunktioner, forretningsmodeller og hele brancher. Anvendelsen af generativ AI er ikke begrænset til data science, men kan bruges bredt i virksomheder. AI og generativ AI kan forbedre produktivitet og kvalitet, støtte menneskelig beslutningstagning, reducere omkostninger samt øge jobtilfredsheden.

Generativ AI er ikke perfekt

Generativ AI er langt fra perfekt og kan være unøjagtig i sine svar. Den arbejder på at forudsige det korrekte svar på en forespørgsel eller anmodning ved at anvende sine algoritmer og datasæt. Dens output kan være meget nyttige, men det kan ligne "første udkast". Derfor bør du altid verificere disse udkast og analysere kvaliteten, og derefter tilpasse dem efter behov. Hvis ikke man konfigurerer eller sikre anvendelsen af generativ AI, så kan den producere irrelevante, unøjagtige, stødende eller juridisk problematiske outputs. Dels fordi brugerne måske ikke giver generative AI-modeller de rigtige inputs, og dels fordi disse modeller af ”natur” er kreative.

I PwC har vi udviklet et AI Compliance Assessment Tool, som er en modenhedsvurdering, der skal give jeres organisation overblik over og indsigt i, hvilke indsatsområder, som I med fordel kan prioritere for at overholde kravene i AI Act. Sammen kan vi sikre, at I opnår værdi ved anvendelse af AI, samtidig med at I overholder lovkravene i den nye forordning.

Udbredelsen af AI medfører flere risici

Der er ligeledes opstået nye cyberrisici i forbindelse med frigivelsen af generativ AI-modeller, herunder muligheden for, at ondsindede aktører bruger disse teknologier til at generere deepfakes og cyberangreb. Fordi flere mennesker end nogensinde kan bruge generativ AI, kan nogle af disse risici også blive mere udbredte. Mange generativ AI-brugere i din virksomhed er måske ikke bekendte med, hvordan AI-modeller fungerer, og hvordan de skal bruges. Derfor er det afgørende for virksomheder, at de etablerer en samlet ansvarlig tilgang til udvikling og brugen af AI, som mitigerer de mange risici.

Generativ AI's nye tillidsudfordringer og hvordan Responsible AI kan hjælpe

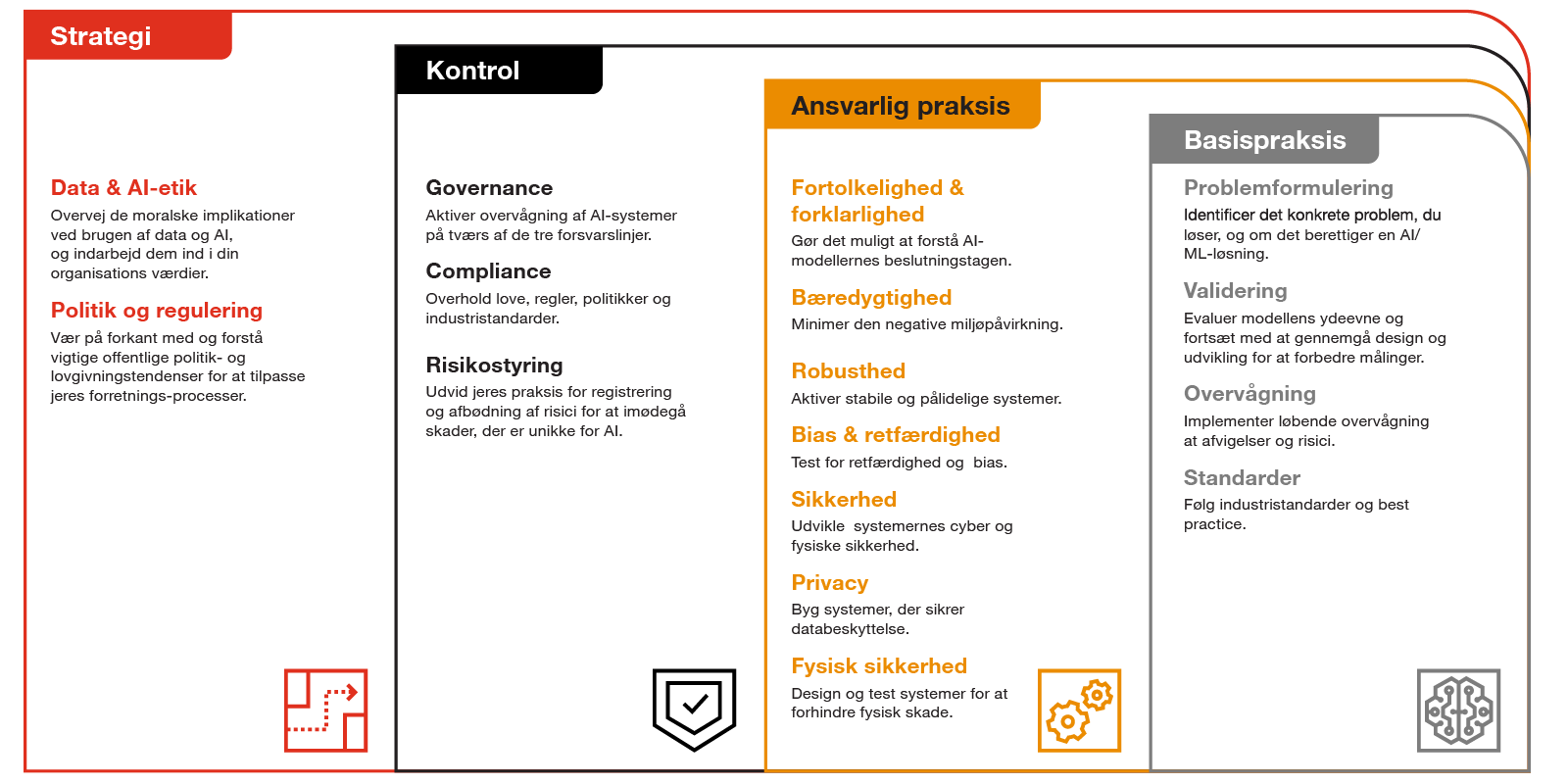

Responsible AI kan hjælpe med at håndtere risici og gældende lovkrav og dermed opbygge tillid til den AI, du køber, bygger og bruger – herunder generativ AI. PwC's Responsible AI, skaber tillid gennem metoder, skabeloner og kodebaserede værktøjer.

Responsible AI går på tværs af virksomheden

Det er særligt vigtigt, at virksomheden fastlægger sin AI-strategi med fokus på også at udvikle politikker for ansvarlig brug af AI, der afspejles i virksomhedens formål og værdier. I den forbindelse er der flere ansvarsområder og roller: CRO’er er ansvarlige for at definere governance, kontroller og risikostyring. CIO’er og CISO’er tager ansvaret for fx cybersikkerhed. Data scientists og forretningsdomænespecialister er ansvarlige for anvendelsen og for at bruge standardiserede praksisser, når de udvikler løsninger, formulerer problemer og input og validerer og overvåger output.

PwC's Responsible AI Toolkit

PwC's Responsible AI Toolkit

I takt med at din virksomhed begynder at udforske mulighederne i AI-anvendelsen, og hvordan man kan anvende AI ansvarligt, er der nogle risici, som man skal være opmærksom på:

Bias, stødende eller vildledende indhold: Ligesom konventionel AI kan generativ AI vise bias mod mennesker, primært på baggrund af bias i dens data. Men risikoen her kan være mere intens, da den også kan skabe misinformation og misbrugende eller stødende indhold.

Nye “black boxes”: Generativ AI bygger normalt på en "foundation model", som en specialiseret tredjepart har bygget. Uden ejerskab eller kontrol over denne model og uden adgang til indsigt i dens 'indre' arbejdsmetoder, kan det være umuligt at forstå, hvorfor den producerer et bestemt output. Nogle generative AI-systemer kan endda ikke afsløre, hvilken tredjeparts AI-model de bruger.

Cyberrisici: Ligesom generativ AI kan hjælpe dig med at producere godt indhold, kan det også hjælpe ondsindede aktører med at gøre det samme. Det kan fx analysere dine indlæg og videoer på sociale medier for at efterligne din skrivestil, talemåde og ansigtsudtryk. Generativ AI kan derfor skabe mails eller videoer, der tilsyneladende kommer fra din virksomhed, hvilket kan føre til spredning af misinformation eller opfordringer til interessenter om at dele følsomme oplysninger.

- Nye brud på privatlivet: Generativ AI's evne til at forbinde data i sine omfattende datasæt (og generere nye data efter behov) kan bryde igennem privatlivskontroller. Ved at identificere relationer mellem tilsyneladende urelaterede datapunkter, kan AI afsløre anonymiserede interessenters identitet og sammensætte disse til personlige oplysninger.

- Hallucinationer, der truer ydeevnen: Generativ AI er god til at komme med overbevisende svar på næsten alle spørgsmål. Men nogle gange er dens svar helt forkerte, men præsenteres autoritativt – hvad data scientists kalder "hallucinationer". Hallucinationer opstår delvist, fordi modellerne ofte er designet til at generere indhold, der virker rimeligt, selvom det ikke altid er korrekt.

Kom godt i gang med at bruge AI og Generativ AI med Responsible AI

PwC har et globalt koncept for udrulning af AI og Generativ AI, herunder ansvarlig brug af AI (Responsible AI). Konceptet kan hjælpe virksomheder med at opnå værdi ved at anvende AI samt med at blive compliant med blandt andet EU-forordningen på AI området (AI Act). Nedenstående er PwC’s implementeringsmodel til AI, hvor fundamentet er Responsible AI.

1. Forretningsgrundlag og use-case identifikation

En omfattende vurdering af forretningspåvirkningen og den økonomiske værdi, baseret på analyse af brugsmønstre og de berørte interessegrupper, er afgørende. Dette danner grundlag for at bestemme den samlede økonomiske værdi og er essentiel for at udforme udrulningsstrategien.

2. Cloud og Data fundament

For at skabe et klart AI-datagrundlag er det essentielt at integrere et it-fundament (Technology & Security Baseline Capabilities), Data Management, Datarens, Databeskyttelse, IAM, PAM og RBAC’s sammen med en ansvarlig anvendelse af AI.

3. Brugerinvovlering

Lager af Top Use Cases og Quick Wins fra identificerede mønstre, prompts, brugerdannelser og forandringsledelse, udrulningskommunikation osv.

4. AI anvendelse og opfølgning

Opbygning og udvidelse af AI-løsninger på tværs af virksomheden, sikret i overensstemmelse med forretningsprioriteter, effektivitet og investeringsafkast. Dette inkluderer også løbende opfølgning på de implementerede løsninger og overvågning af deres performance ved hjælp af relevante målepunkter.

PwC tilbyder et AI Compliance Assessment Tool til vores kunder

I PwC arbejder vi ud fra en ansvarlig tilgang (Responsible AI), hvor vi hjælper jeres virksomhed med at opnå værdien ved anvendelse af AI samt med at leve op til compliance-krav. Som led i dette har vi et AI Compliance Assessment Tool, som er en modenhedsvurdering, der skal give jeres organisation overblik over og indsigt i, hvilke indsatsområder man bør prioritere for at overholde kravene i AI Act.